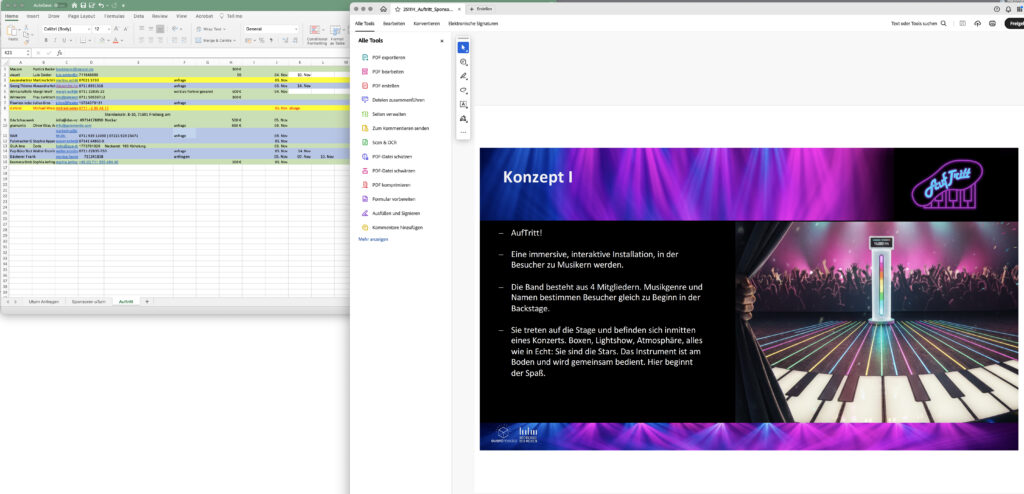

Live Publikum oder doch nur eine Simulation? – Die Bildebenen bei AufTritt

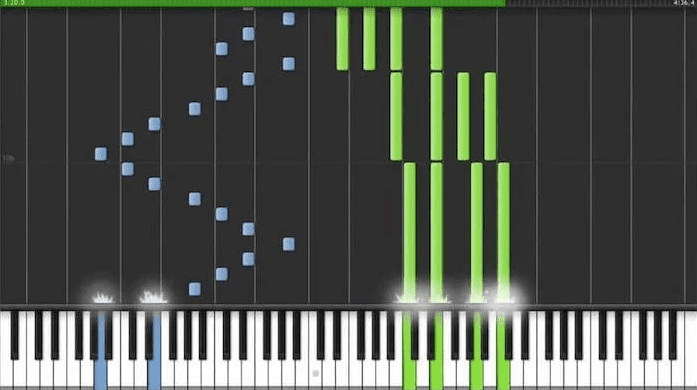

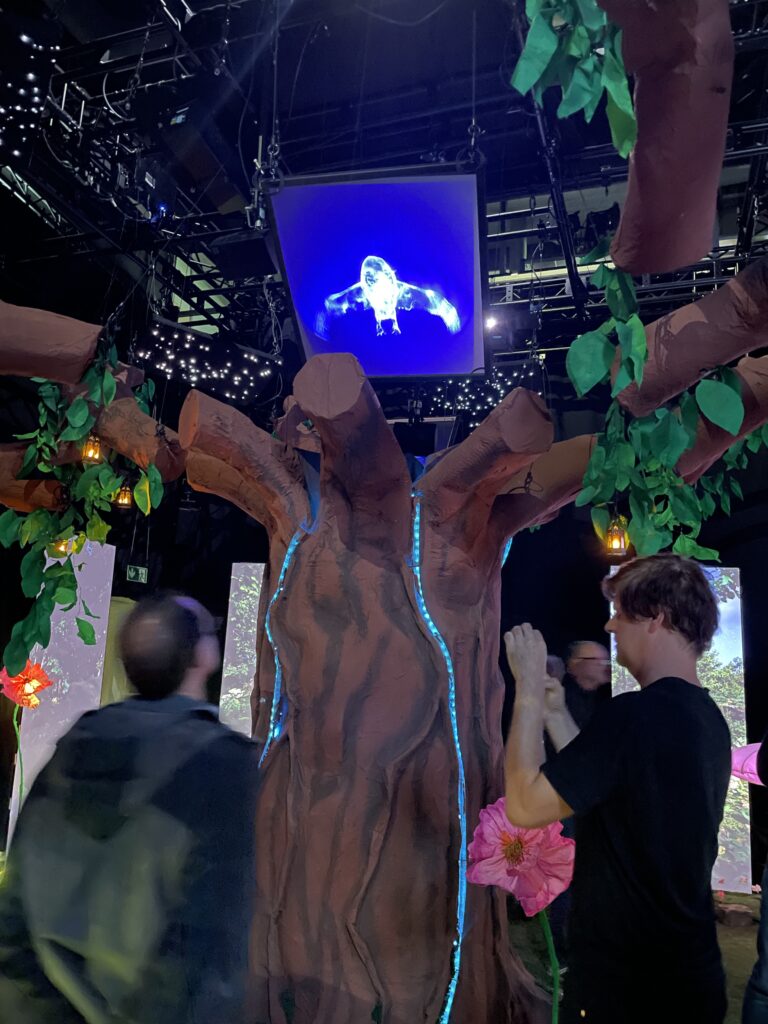

Die Erlebnisinstallation „AufTritt“ verbindet vier Spieler zu einer Band und lässt diese in die Welt eines Konzertauftritts eintauchen. Die Band bildet sich im Backstage Bereich, wählt dort einen Bandnamen und läuft anschließend durch einen Gang hintenrum auf die Bühne. Dort erwartet die Spieler ein eindrucksvolles Bild. Eine große offene Bühne, viele Lautsprecher, Lichter, LED-Streifen auf dem Boden, eine große LED-Wand und das Herz des Spiels – das große klavierähnliche Instrument auf dem Boden, das mit den Füßen bedient wird. Jeder Spieler hat fünf Tasten vor sich. Das Spielprinzip ist einfach: Passend zur Musik läuft ein Lichtsignal durch die LED-Streifen auf dem Boden auf die Spieler zu. Sobald das Signal bei einem Spieler ankommt, leuchtet eine der fünf Tasten auf und der Spieler drückt die Taste mit dem Fuß. Je besser der richtige Zeitpunkt erwischt wird, desto mehr Punkte gibt es.

Die Spielidee steht und die Aufgaben des Spielers sind klar. Zur Stirnseite wird eine grosse LED Wall aufgebaut. Dort befinden sich die virtuellen Fans. Dieser Beitrag beschäftigt sich mit der Gestaltung der LED-Wand und welche Herausforderungen uns hierbei begegnen.

Umrisse und Silhouetten eines Publikums um die Spieler herum sind sichtbar. Dieses Publikum reagiert auf die Leistung der Spieler-Band. Je besser gespielt wird, desto lauter wird der Jubel im virtuellen Publikum, den Fans. Die Spieler bekommen das Gefühl, dass ihre Leistung auf der Bühne zählt und das Publikum mitgeht. Wie setzt man diese Idee am besten in die Tat um?

Die Positionierung von Bildschirmen und visuellen Einflüssen im Raum spielt eine wichtige Rolle für das Erlebnis der Spieler. Sollen die LED-Wände im Halbkreis stehen oder als gerade Wand? Sind zwischen den Bildschirmen Lücken sichtbar oder schliessen zusätzliche Pappaufsteller diese Lücken? Letztendlich füllt eine gerade, durchgehende LED-Wand die gesamte Breite des Raums aus, ohne Pappaufsteller oder Lücken zwischen den einzelnen Paneelen. Die Spieler*innen gewinnen den Eindruck, dass der Raum durch eine LED Wall erweitert wird, dass tatsächlich Publikum, wie bei einem echten Konzert, auf die Performance reagiert. Das wird durch typische Konzert-Absperrgitter (sogenannte Wellenbrecher) vor der LED-Wand verstärkt.

Wie sieht das virtuelle Publikum aus?

Möglichkeit 1: wir nehmen ein Publikum aus echten Menschen mit Kameras auf und lassen diese Videos auf großen Bildschirmen abspielen. Dagegen sprechen folgende Argumente:

- Es reichen Silhouetten.

2. Die Reaktionen des virtuellen Publikums werden live und flüssig auf die Bandperformance reagieren. Ein Übergang von einem zum anderen Video ist unerwünscht. Daher scheidet dieser Gedanke aus.

Möglichkeit 2: Die Personen sind am Computer animiert.

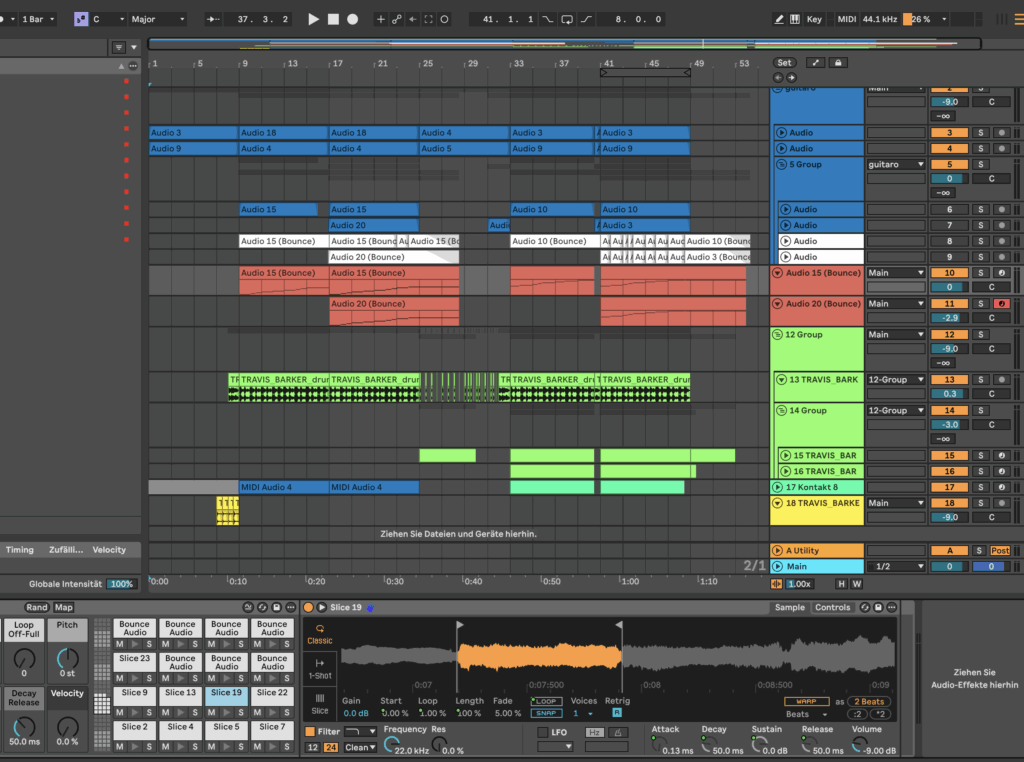

Ingrid Kaub aus dem Bewegtbild-Team beschäftigt sich mit der Live-Animation des Publikums mit der Unreal Engine. Da niemand von uns Erfahrungen mit der Unreal Engine hat, arbeitet sie sich mithilfe von Tutorials in das Thema ein.

Herausfordernd bei dieser Aufgabe ist zum einen das Erstellen von großen Menschenmengen, die beliebig verkleinert oder vergrößert werden. Mit dem “Procedural Content Generator” der Unreal Engine ist es möglich, große Mengen mit unterschiedlich aussehenden Menschen zu erstellen. Da es unser Konzept vorsieht, die Personen nur schemenhaft darzustellen, ist ein realistisches und diverses Aussehen der Figuren nicht so wichtig. Die unterschiedlichen Personen-Modelle sind allerdings auch für deren Animation und Bewegung relevant, damit nicht alle Personen die gleichen Tanzbewegungen haben.

Ein weiteres Hindernis sind die verschiedenen Emotionsstufen der Menschenmenge.

Die Menge reagiert je nach Leistung und Genauigkeit der Spieler unterschiedlich auf die gespielten Töne. Ein flüssiger Wechsel zwischen verschiedenen Animationen ist wünschenswert. Dies ermöglicht das “AnimBlueprint” System von Unreal Engine. Damit setzen wir die Live Steuerung der Simulation um. Wie gut das am Ende funktioniert, finden wir noch heraus.

Außerdem muss es möglich sein, eine Schnittstelle zwischen Unreal Engine und Touchdesigner herzustellen. Die Menschenmenge reagiert direkt auf die Spielereingaben, ohne dass wir als Zwischenschritt manuell eingreifen. Diese Aufgabe liegt aktuell vor uns und wird noch bewältigt. Wir freuen uns schon sehr auf das Endergebnis und hoffen, dass die Wirkung am Ende genau so beeindruckend sein wird, wie wir uns das vorstellen. Stay tuned.

Beitrag von Svenja Regber

Fotos, Screenshots und Konzeptskizzen © Studioproduktion Event Media Auftritt